|

●グリッドコンピューティングの動向とそれを支える技術●

第1回 グリッド・コンピューティングの始まり

日本アイ・ビー・エム㈱ グリッド・ビジネス事業部 技術理事 関 孝則

昨今、一般の新聞紙上をまで賑わすようになった新しい技術、"グリッド・コンピューティング"。この連載では前半、IBMからグリッド・コンピューティングの始まり、その現在とビジョン、実際はじまっているグリッドのビジネス利用を紹介していき、後半、NTTデータさまの実際のグリッド・プロジェクトであるCell

Computingプロジェクト、そのビジネス化、技術戦略という話につないでいきたいと思っている。

■グリッド・コンピューティングとは?

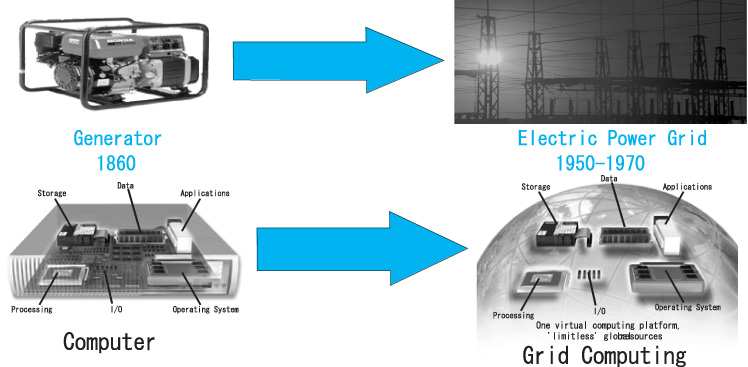

グリッド・コンピューティングはその語源はパワー・グリッド(電力送電網)のグリッドからきている。電気の世界は発電機に始まり、最終的に現在、たくさんの発電所、送電網が入り混じって構成されている中で、一般のユーザーはブレーカーさえ落ちなければ、どんな使用状況でも一定のサービスを受けられている。どこに発電所があるか、どこから送られてきた電気かはいっさい意識する必要はない状況だ。この類似の考え方で、世界中のたくさんのコンピュータをネットワークで接続することで、ユーザーには、どこで計算されているか、どこにデータがあるかは意識せずに、一定のコンピュータ・サービスを受けることができないか、ということで考えられたのがグリッド・コンピューティングだ。言い換えれば、たくさんの広く分散したコンピュータを接続して、仮想的な大きなコンピュータを実現しようとするものといえる。

図1 グリッド・コンピューティングとは?

■グリッド・コンピューティングの始まり

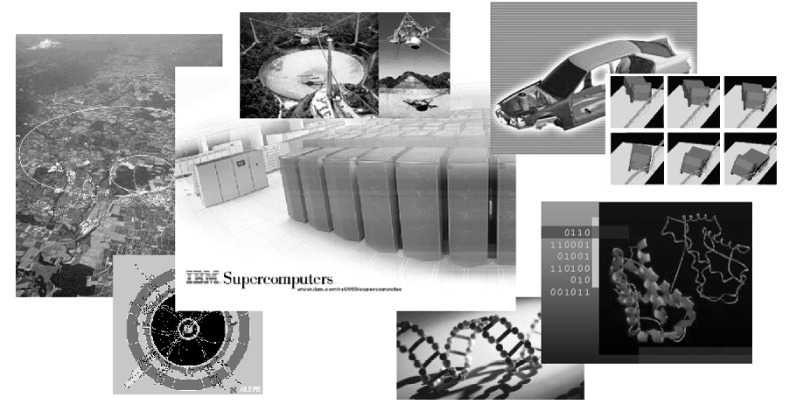

グリッド・コンピューティングの原点は、当初サイエンス、学術的なエリアでその必要性が認識され、実現の試みがされてきた。90年代、そして昨今のサイエンスは、巨大な実験設備、観測機などが備えられ、多くの研究者がそれを共用し、かつ共同研究することで、新たな科学分野の発掘が行われている。俗に言う『ビック・サイエンス』といわれるものである。

図2の左にある欧州のCERN(http://public.web.cern.ch/)という粒子加速器では、粒子同士が衝突させられ、実施の1回の衝突はごくわずかな時間でも、毎秒になおすと数ペタバイトのデータが生成される。これらの大量データを年間さらに数年にわたって格納するだけでなく、それを研究者のニーズで取り出し、さらにいろいろな計算によって研究を進めていこうとすることは、過去のIT資源と技術ではかなりの困難さを伴うことであろう。彼らは膨大な観測データを世界中の計算センターに分散して置き、それを一つの巨大な計算機としてみせることにより、研究者のニーズに答えるということを考えた。CERNのデータ・グリッドのプロジェクトがこれである。

図2 ビック・サイエンスが求めたグリッド・コンピューティング

また中央上にある巨大な電波望遠鏡は、全天の星からのデータを集めてくる。集められたデータは、世界中のインターネットで繋がった一般のユーザーのPCに送られ、その中から自然に発生する電波の波形パターンでなく、人間が発するように人工的に作られた電波を探すように各々のPCでアプリケーションが実行され、その答えが毎日集められている。これがグリッド・コンピューティングの例として有名なSETI@HOME(http://setiathome.ssl.berkeley.edu/)プロジェクトである。インターネットを介して膨大なPCが接続され、巨大なスーパーコンピュータが形成されているのである。

このように近年のサイエンスは、ビック・サイエンスと呼ばれるように、巨大な機器を使い、巨大なデータを扱い、巨大な計算をし、たくさんの研究者が係わって研究が行われていく傾向が強くなってきている。原子力技術のシミュレーション、ライフサイエンス分野での膨大な検索と計算、生物をシミュレーションしようとするインシリコというテクノロジー、構造物のより動的なシミュレーション、こういった膨大な計算とデータのニーズはとどまるところを知らない。さらにこういった傾向は産業界にも押し寄せ、ライフサイエンスは製薬へ、構造物の衝突シミュレーションは自動車産業へと、いろいろな産業界に応用されている。

このようにビック・サイエンスは、組織を超えて分散したいろいろなコンピュータを接続し、グリッド・コンピュータを形成し、スーパーコンピュータでも満たせないような、また地球規模での研究者が同時にデータを使える環境などの、巨大な仮想的なコンピュータ環境を実現するグリッド技術を推し進める原動力となっている。

■ビジネスでのグリッド・コンピューティングのニーズ

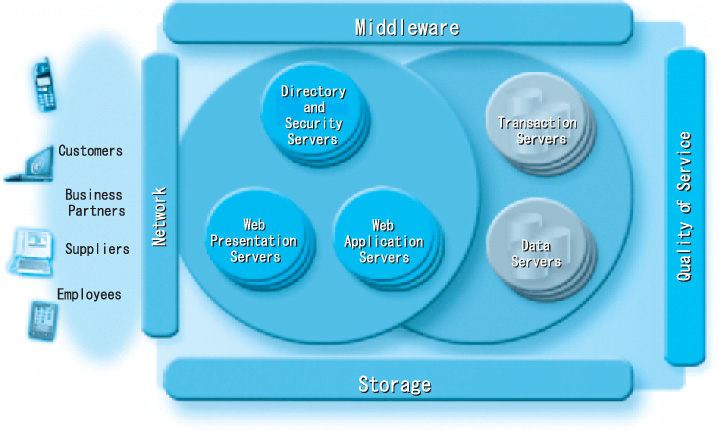

それでは、ビジネスの世界ではどうだろうか。グリッドのようなニーズはあるのだろうか。昨今のe-ビジネスを実現するためのインフラは、多様なかつ膨大なインターネットからのトランザクションに悩まされている。インターネットを介したアクセスは、特定の時間や特定のコンテンツに集中することは頻繁である。それに対応するために、拡張性や可用性を向上させるべく、e-ビジネスのインフラも多くのサーバに分業されている。インターネットからのリクエストを受けたり、Webページのプレゼンテーションを担当するWebサーバ(プレゼンテーション・サーバ)、その後ろで具体的なアプリケーションのロジックを実行するWebアプリケーションサーバ、そして最終的にビジネスデータを取り出したり、更新したりするデータベース・サーバである。

さらにその周辺にはエッジサーバ、ディレクトリーサーバ、セキュリティ系のサーバなどさまざまなサーバが稼動している。そして各々の役割のサーバは必要に応じて可用性を高めるためにさらにクラスタリングなどの複数台構成となっている。また各々の役割のサーバはその性質、開発環境、企業の過去の資産といった制約から多くの場合、メインフレーム、UNIX、PCサーバなど異機種で構成されているのが常である。またe-コマースのような環境の場合、この異機種で分散した環境はさらに企業の枠を超えて他企業とも接続されてくることとなってくる。このように一見ユーザーからは一つのサーバのように見えるインフラはすでに複数台で、かつ組織、企業を超えて、異機種で分散した環境を作りだしている。しかしユーザーからみれば、常に一つのシステムとしてサービスが提供されるべきであろう。まさにサービス品質であるQoS(Quality

of Service)が組織を超えた異機種・分散の環境で必要となっているのだ。以前は単一の機種で集中した環境において追求されてきたQoSが、組織を超えて異機種で分散した環境でも追求しなければならない、これはまさに大きなチャレンジといえるであろう。

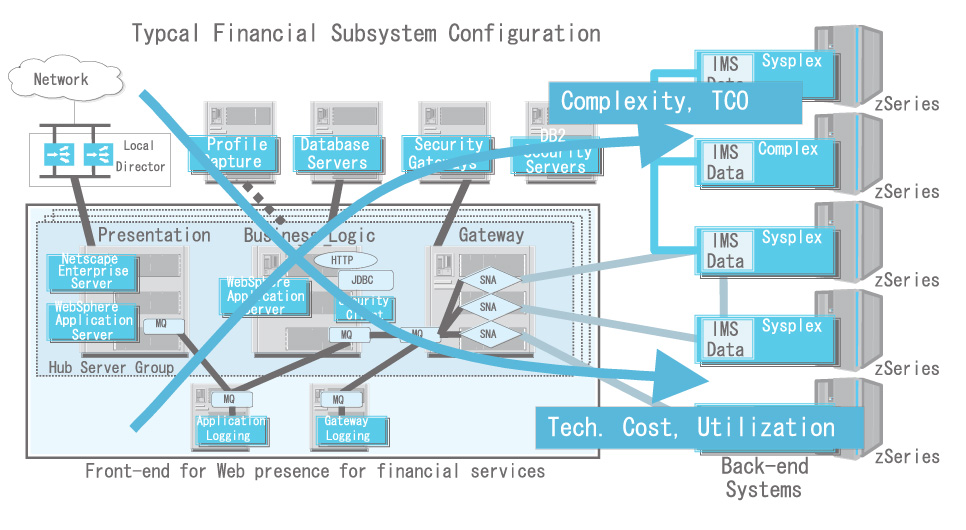

またこれらは単に組織を超えた、異機種、分散の環境の中でQoSを実現しなければいけないというニーズだけでなく、すでに数々の問題をそのインフラに抱えている。テクノロジーはものすごい勢いで低価格化し、それがインフラ構成要素の複雑化をいっそう推し進めてきている。一方、クラスタリングなどを代表とするシステムの可用性のための冗長化は、システム全体としての平均使用率を下げている。予測不可能なトランザクションが発生するおそれがあるe-ビジネスインフラでは当然のことであろう。

図3 e-ビジネス・インフラの現状

一方、インフラの複雑度は、構成されるコンポーネントの数を考えると年々増加の一途をたどっている。これは可用性の向上という課題に対する対応という理由だけでなく、本来新しいビジネスをe-ビジネスインフラ上に築くということ自体が、新たなシステムの接続の必要性を増すという、ビジネス上のニーズからの現象といえるものだろう。このようにシステムの複雑度が増すということは、必然的にそのインフラを維持するためのコストの増加、TCO(Total

Cost of Ownership)の増加につながることは言うまでもない。

昨今、IT情報誌などを眺めていると、頻繁にe-ビジネスインフラのトラブルが掲載されている。そのストーリーがほとんどの場合、問題が起こってもどこが悪いのか、どうやったら直るのかという、複雑化したインフラに対するチャレンジの側面を帯びている。しかし、現実にこれだけ異機種の、場合によっては組織をまたがったシステムに対して、すぐに問題解決をできるスキルをもったエンジニアを探すのはほとんど不可能に近い。このように使用率の低下、TCOの増加、そしてそれに対するスキルの欠如といった根本的問題が日々明らかになってきている。

さて、これらの課題に対してインフラを単一のメインフレームないし、UNIXで構築するという選択肢もあり得る。しかし、すでにビジネスが複数の組織、しかも資本関係のない組織で成し得る昨今の経済では、この選択肢は不可能といわなければならないだろう。つまりe-ビジネスのインフラにおいて、組織を超えて、異機種で、分散した環境のインフラはまさに必然的な現象といえるのではないだろうか。そしてそこでQoSを実現しTCOを下げるというチャレンジは、その環境をいかにシンプルに扱えるようにするか、言い換えればシンプルに仮想的な計算機として扱えるかという技術の必要性を暗示している。これはまさにビック・サイエンスが、仮想的な巨大なコンピュータを実現しようとしていた、グリッド・コンピューティングというアプローチの別アングルからの実現といえるであろう。

図4 e-ビジネス・インフラの課題

NEXT >>

|